Chi Siamo

Chi siamo People Art basa la sua attività su una lunga esperienza manageriale interna ad aziende con attività internazionali...

IL CONFRONTO AL TEMPO DEL WEB

Foto di memyselfaneye da Pixabay

1. INTRODUZIONE

Nei mesi scorsi, alcuni eventi, fra cui fake news con conseguenze politiche, hanno portato l’attenzione su come funziona il confronto di opinioni nel web e su come i dati degli utenti vengono utilizzati per influenzarci (1), spesso sotto il travestimento di servizi che “ci facilitano la vita”.

Le fake news (la Disinformazione) sono sempre esistite, ma non cessano di destare preoccupazione. Già nel 2013, il World Economic Forum (WEF) ha cominciato a segnalare il fenomeno come uno dei principali rischi globali (i “digital wildfires” compaiono nel report Rif.1, e poi in quello 2018: Rif.2). Commissione Europea (Rif.3, 23) e Congresso USA (2) se ne stanno occupando proprio adesso.

La ragione di questo allarme, anche in Italia (3), risiede nel fatto che alcune caratteristiche delle fake news (es. facilità di produzione, influenza efficace, velocità di diffusione) sono state esaltate/ accelerate dal canale web.

Troppo facilmente se ne trae la conclusione che serve una sua stretta regolazione: vedremo che se il web è il media e l’acceleratore, non è la causa della disinformazione. Le cause sono dovute ad attitudini del tutto umane, individuali e di gruppo (Paragrafi 2 e 3).

Vale la pena comprendere meglio quali sono queste attitudini e di come operano (Paragrafo 3), con o senza l’ausilio tecnologico. Emergerà un quadro in cui prevenzione e contrasto debbono essere agiti a tre livelli:

2. BIAS COGNITIVI

Si da per scontato che l’uomo sia un animale razionale e “sociale”, ma quanto effettivamente siamo razionali ed in che modo siamo sociali sono aspetti rilevanti per come funziona la disinformazione.

Da tempo le ricerche sulle capacità cognitive hanno evidenziato come usiamo la Razionalità in modo molto limitato. Non la usiamo sempre e quando pensiamo di farlo spesso è un’illusione (Rif.6, 7, 8, 9, 10).

Nella maggioranza dei casi, anche quando la mente opera in modo “consapevole”, si basa su schemi di pensiero e comportamentali standardizzati. Questi schemi sono modalità semplificate di valutazione, decisione e comportamento. Potranno ulteriormente mutare, ma per ora si sono consolidate come caratteristiche della nostra specie (Rif. 11).

Si basano su pochi elementi chiave del contesto, naturale e sociale, in cui ci siamo evoluti. Si sono mantenuti sino a noi perché in grado di farci raggiungere, con una elevata probabilità, scopi come l’efficacia sociale e la sopravvivenza.

Tuttavia, non è detto che possiamo aspettarci la stessa efficacia affrontando nuove situazioni o contesti (Rif.12), come quelli artificiali del “mondo costruito da noi”. Sono i Bias Cognitivi (Deviazioni Cognitive: per un elenco dei più diffusi Rif.11).

Vediamo quelli collegati con la diffusione della disinformazione e come il web ne amplifica gli effetti.

3. UNO SCENARIO DI FRAMMENTAZIONE

Ai suoi albori, si pensava al web come luogo per un confronto di opinioni globale ed aperto. Capace di favorire lo sviluppo di una “intelligenza collettiva globale” (Rif.6).

A meno di un decennio, questa visione ottimistica è sostituita da uno scenario opposto (Rif.6, 7, 8, 9, 10):

Proverò a mostrare in 3 figure alcuni dei fenomeni alla radice di questa evoluzione.

(4) Vedi ad esempio: https://mosaicscience.com/story/why-good-people-turn-bad-online-science-trolls-abuse/ oppure la finestra sul “sentire della gente” che alcune trasmissioni a microfono aperto offrono (es. “La Zanzara” di Radio24)

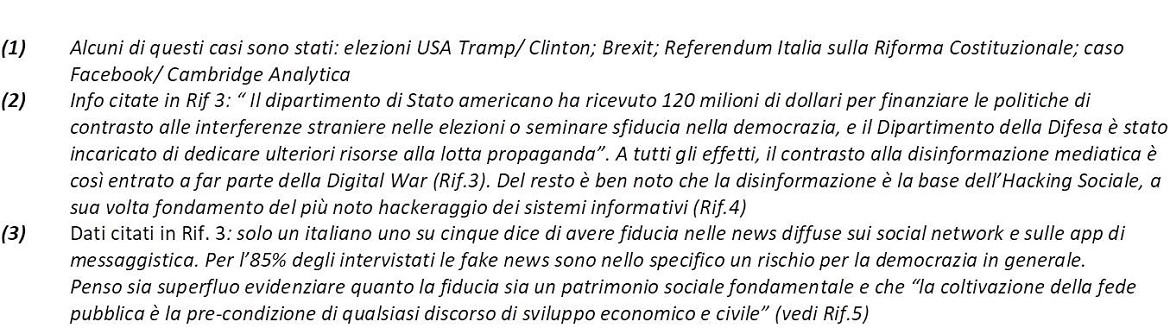

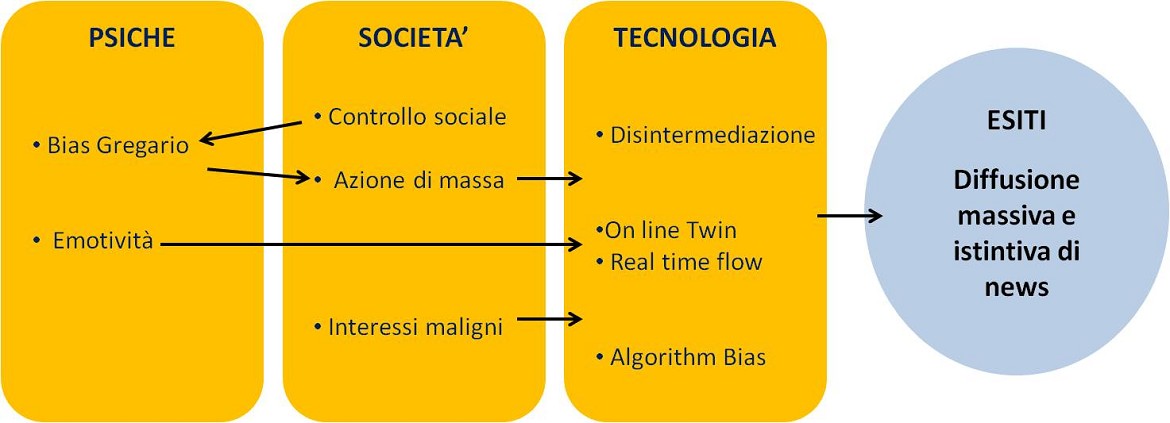

3.1 Utente = Fonte editoriale (Narcisismo, Individualismo, Disintermediazione)

Figura 1

La tendenza al narcisismo (“mettersi al centro a scapito degli altri”) è aumentata negli ultimi anni (Rif.6).

Ci spingono vari fenomeni sociali fra cui: più difficile salire la scala sociale o trovare un lavoro, illusioni di successo senza impegno, modelli che-sei-un-leader-o-sei-nessuno, ecc., oltre la tendenza alla frammentazione individualista (“l’importante è che me la cavi io”).

Narcisismo e Frammentazione si sposano con la disintermediazione della comunicazione, resa possibile dal web. Pubblichiamo direttamente i nostri audio, video, articoli (come questo), commenti. Persino le versioni che preferiamo della nostra storia (profili professionali o personali) e delle nostre più minute vicende ed emozioni (blog): ognuno di noi diventa una Fonte Editoriale autonoma.

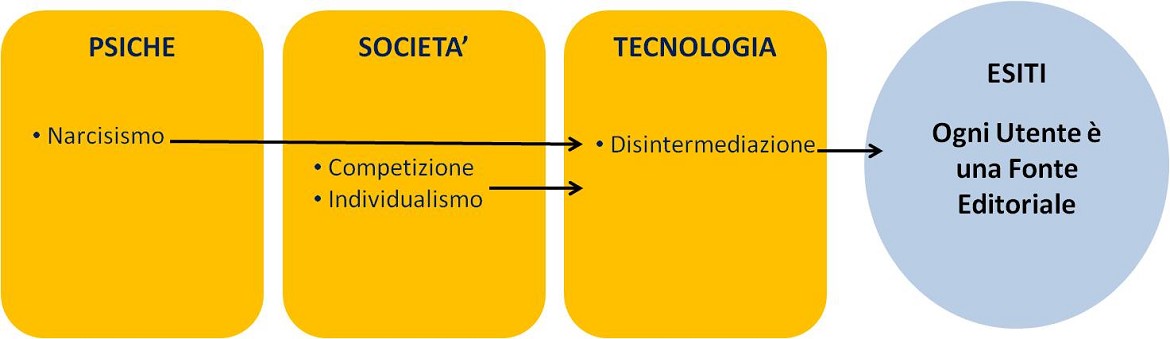

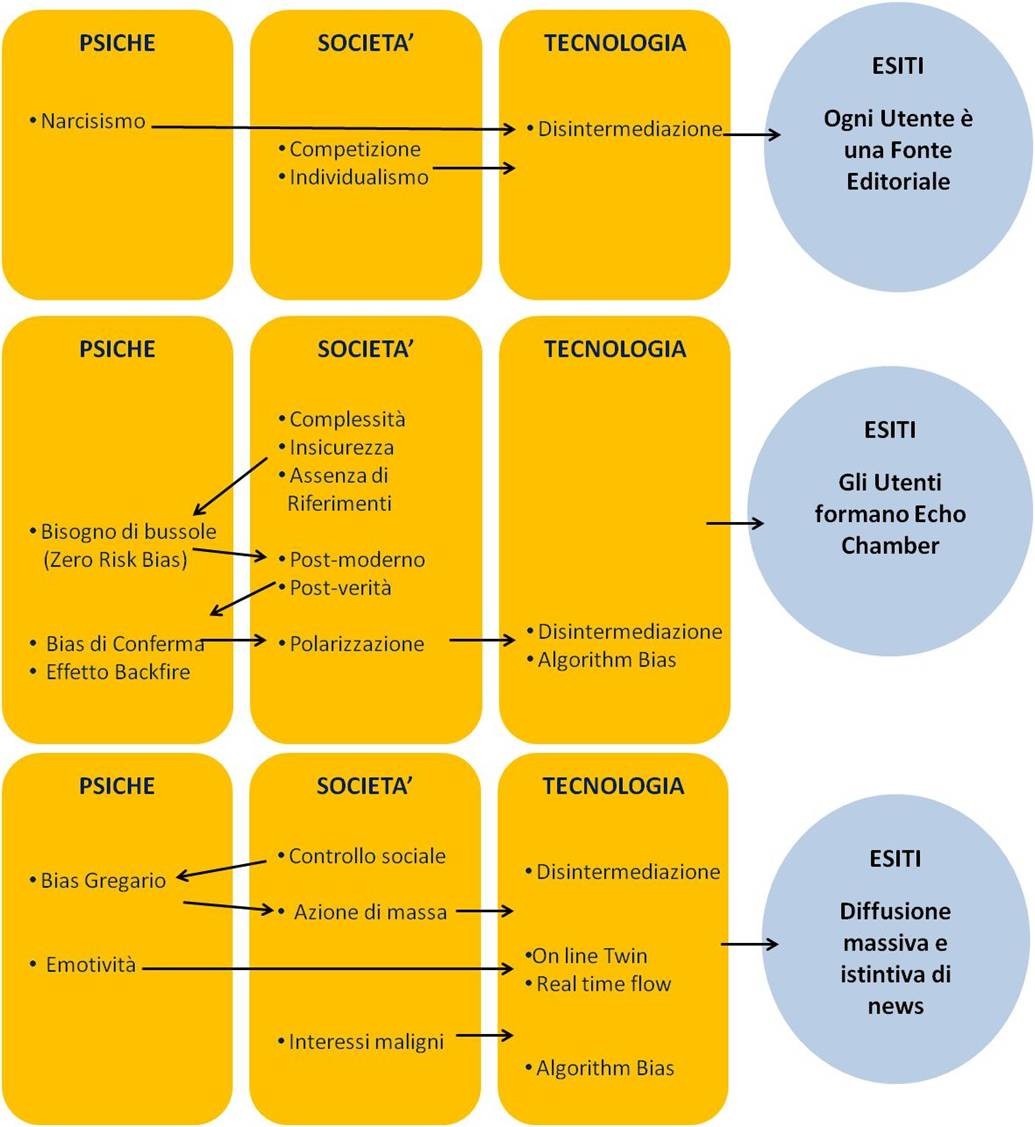

3.2 Echo Chamber = opinioni autoreferenziali (Complessità, Insicurezza, Bisogno di Conferma)

Figura 2

La complessità del mondo in cui viviamo ce lo rende sempre meno comprensibile (Rif.14). Ne consegue spaesamento e bisogni molto forti di sicurezza, ancoraggio, senso.

Le spiegazioni migliori sono quelle che noi stessi siamo in grado di formulare o capire.

Approccio in linea col pensiero Post-moderno (“non ci sono fatti, solo interpretazioni”) e poi confermato dalla sua forma popolare, la Post-verità: “non c’è una cosa vera, ci sono molte verità sulla stessa cosa” (Rif.15). Le opinioni, da possibili interpretazioni che è opportuno confrontare, divengono verità inattaccabili per cui ogni confronto è un affronto.

“E’ vero se lo credo io” implica il bisogno di conferma sociale perchè dà solidità alla propria identità. Di questo si alimentano il Bias di Conferma: cercare e dare più ascolto a fonti, opinioni, persone che confermano quello che noi stessi pensiamo e le sue conseguenze:

La conferma della mia-verità ed il rifiuto di opinioni diverse portano alla Polarizzazione del confronto ed al passaggio confronto-scontro (Rif.6). Le conversazioni assumono una struttura chiusa su opinioni simili (Echo Chamber) (Rif.7).

La tecnologia contribuisce alla chiusura, ad esempio con gli algoritmi che forniscono informazioni coerenti con le nostre preferenze (Algorithmic Bias) (Rif.18, 19). L’esempio più diffuso lo si trova nel funzionamento di Google.

3.3 L’informazione cattiva scaccia quella buona (Bias Gregario, Delegittimazione dell’autorevolezza, Disinformazione)

Figura 3

Il processo di selezione continuo sulla accettabilità delle opinioni scambiate nelle Echo Chambers diventa un vero processo di Controllo Sociale. Ne risulta un ambiente Identitario su cui fa presa il Bias Gregario (Bandwagon Effect).

Un utente emula attivamente altri che sente simili, generando un effetto a cascata: dai più attivi, ai meno attivi per coinvolgere infine anche i dubbiosi.

Questa volta, la tecnologia è un accelerante grazie all’aumento del tempo di esposizione alla rete (es. tramite gli smartphone), o alla semplicità delle app che abilitano l’immediatezza dell’interazione (scambi basati più su indignazione, rabbia, commozione, ecc. che su riflessione, riesame dei flussi di eventi e contenuti).

Ecco bello e pronto l’ambiente base per favorire la tempesta perfetta delle fake news digitali.

Una Fake News può nascere all’interno di una Echo Chamber, o esservi iniettata dall’esterno. Il produttore può addirittura essere un bot redattore di testi. Una volta all’interno della Echo Chamber si diffonde rapidamente.

La diffusione è refrattaria ai metodi più sofisticati di Smascheramento (Debunking) a causa dell’effetto Backfire. Anzi, diversi studi sembrano mostrare che si genera un effetto contrario: screditare una fonte ne rinforza l’uso sino ad un +30% (es. Rif.7).

Infine, la Disinformazione si diffonde molto meglio della informazione di qualità perchè costruita per far leva sul tendenze come la preferenza per:

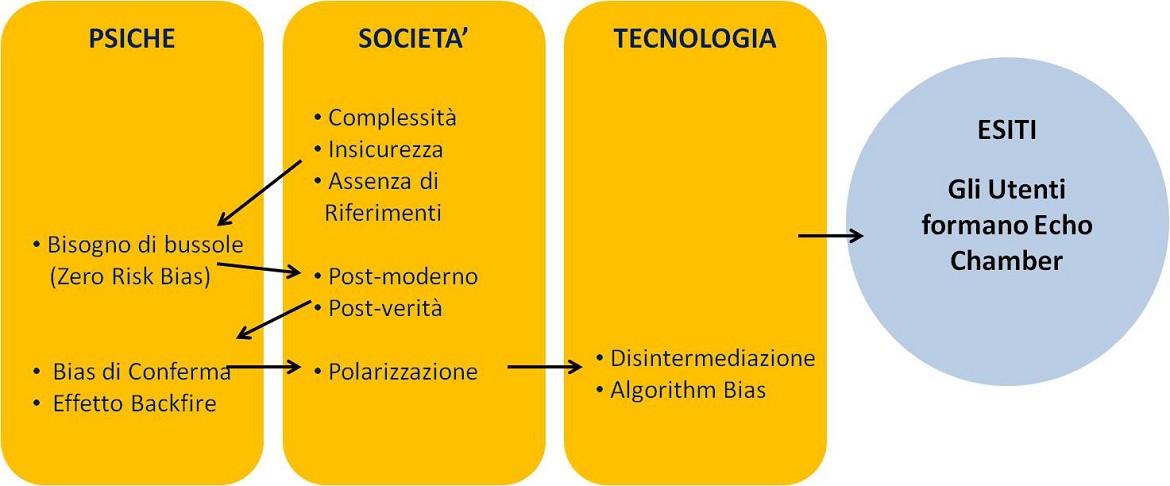

4 I LIVELLI DI CONTRASTO

Uno sguardo al fenomeno nel suo insieme (Figura 4) pare mostrare che la Tecnologia (web, piattaforme di social media, smartphone, bot, ecc.) sostanzialmente svolga una funzione di amplificazione ed accelerazione di fenomeni che hanno radici piuttosto nelle dimensioni della nostra natura psicologica e sociale.

Figura 4

Radici alimentate a loro volta dal non riconoscimento della presenza dei bias dei nostri “ragionamenti” (“Bias? Nessuno mi condiziona”). E’ il Bias del Punto Cieco (Blind Spot Bias), il più subdolo: maschera la consapevolezza che funzioniamo con molti limiti, che molte delle nostre certezze sono fallaci, che le nostre opinioni spesso non hanno nulla di originale essendo reazioni stereotipate a certi stimoli.

Le azioni di contrasto della dimensione Pubblica stanno quindi convergendo, in modo equilibrato, su tutte e tre le dimensioni (Rif.3 e Rapporto della Commissione Europea in Rif.23). Ad esempio:

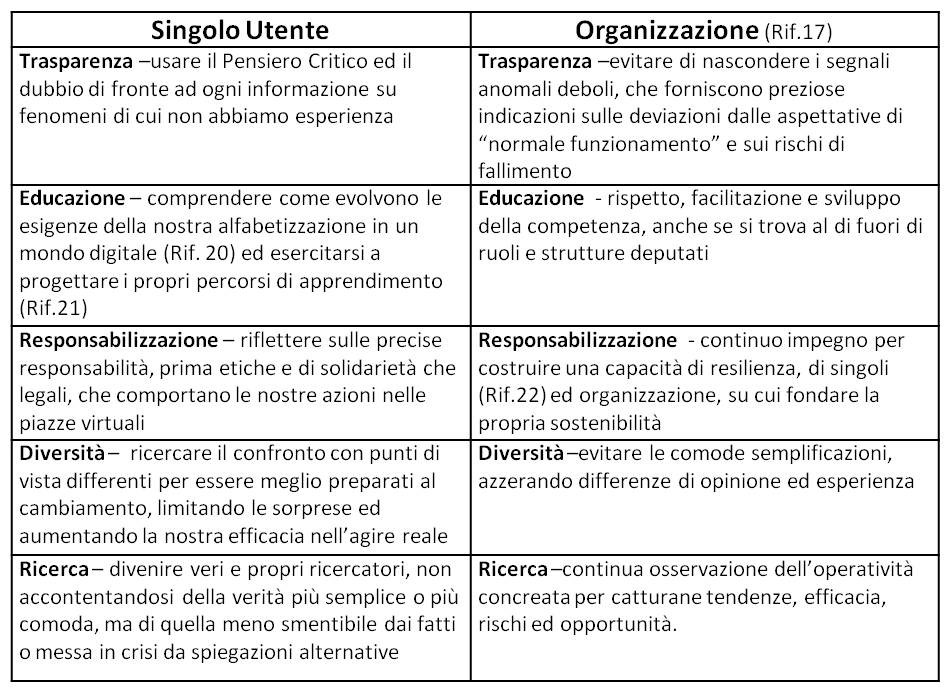

Queste cinque direzioni forniscono uno spunto d’azione anche a livello di Utenti singoli e di Organizzazione (Tabella 1). Nelle organizzazioni, le stesse interazioni che nelle Figure 1, 2 e 3 hanno luogo fra la dimensione Psicologica e quella Sociale avvengono anche li: Group Thinking (Bias Gregario), Bisogno di Conferma, Narcisismo e Competizione individuale, Punti Ciechi e Silos (Echo Chamber), ecc.

Senza neanche il bisogno di un accelerante tecnologico. Dispongono già di validi sostituti come: dinamiche di “piccolo mondo”; funzionamento gerarchico; sistemi di rinforzo (promozioni, sanzioni, riconoscimenti); processi di governance.

Tabella 1

5 ALTRI SPUNTI PER APPROFONDIRE

Rif.1 WEF – Global Risk Report 2013 http://reports.weforum.org/global-risks-2013/risk-case-1/digital-wildfires-in-a-hyperconnected-world/?doing_wp_cron=1523714993.5722019672393798828125

Rif.2 WEF – Global Risk Report 2018 http://reports.weforum.org/global-risks-2018/digital-wildfires/

Rif.3 “Fake News – Burla o complotto”, A.Migliorati, 2018, ebook Radio24, scaricabile da: http://www.utility.ilsole24ore.com/radio24/fake-news.pdf

Rif.4 “L’arte dell’Inganno – I consigli dell’hacker più famoso del mondo”, K.D.Mitnick, 2005, Feltrinelli

Rif.5 “L’economia civile”, L.Bruni, S.Zamagni, 2015, il Mulino (disponibile anche in formato Kindle).

Rif. 6 “Liberi di crederci – Informazione, Internet e Post-verità”, W.Quattrociocchi, A.Vicini, 2018, ed Codice per Le Scienze

Rif.7 “Il Tribalismo e l’idea di verità”, M.Fisher, J.Knobe, B.Strickland, FC.Keil, Le Scienze, aprile 2018

Rif. 8 “La Babele di Internet”, W.Quattrociocchi, Le Scienze nr.596, aprile 2018

Rif.9 “Capacità cognitive e vulnerabilità alle fake news”, D.Z.Hambrick, M.Marquardt, MIND nr 160, aprile 2018

Rif.10 “L’era della disinformazione”, W. Quattrociocchi, Le Scienze nr.570, febbraio 2016

Rif.11 Una ventina di questi schemi o Bias cognitivi, sono stati identificati con alcune attività di ricerca dell’Università di Harvard e sono sintetizzati nella grafica in https://tinyurl.com/yby7fofe (fonte citata in Rif. 6)

Rif.12 “Decisioni Intuitive”, G.Gigerenzer, 2008, Raffaello Cortina ed.

Rif.13 “Le singolarità della specie umana”, P.Teilhard de Chardin, 2013, Jaca Book

Rif.14 “Passaggio ad Occidente”, G.Marramao, 2003, Bollati Borienghieri

Rif.15 “Postverità ed altri misteri”, M.Ferraris, 2017, Il Mulino

Rif.16 Su alcuni casi emblematici di post verità in India: https://www.nature.com/articles/d41586-018-04119-y?utm_source=briefing-dy&utm_medium=email&utm_campaign=briefing&utm_content=20180406

Rif.17 “Governare l’inatteso”, K.E.Weick, K.M.Sutcliffe, 2010, Raffaello Cortina

Rif.18 Project of the Royal Society on the Algorithmic Ethic https://royalsociety.org/topics-policy/projects/machine-learning/ (Fonte citata nel Rif.20)

Rif.19 Horizon’s Research Project about how emancipate users from Algorithmic Biases https://www.horizon.ac.uk/project/unbias-emancipating-users-against-algorithmic-biases-for-a-trusted-digital-economy/ (Fonte citata nel Rif.20)

Rif.20 Corso on line “Learning in the Network Age”della Southampton University sulla piattaforma FutureLearn: https://www.futurelearn.com/courses/learning-network-age/ )

Rif.21 https://www.slideshare.net/domfama/labor-sailing-1

Rif.22 https://www.peopleart.it/it/news-23/resilienza-parte-1-cos-e.html e https://www.peopleart.it/it/news-24/resilienza-parte-2-cosa-allenare.html

Rif.23 “Final Report of the High Level Expert Group on Fake News and Online Disinformation”, Commissione Europea, Aprile 2018 http://ec.europa.eu/newsroom/dae/document.cfm?doc_id=50271